Una moderna auto elettrica può arrivare a usare circa 3.000 semiconduttori, quasi il doppio delle auto tradizionali.

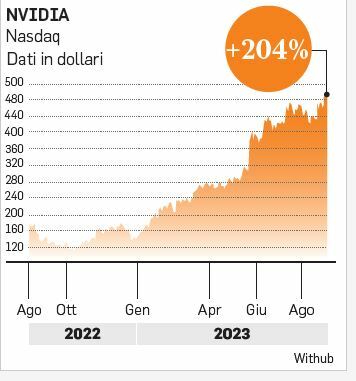

Mentre l’intelligenza artificiale (AI), il cuore della guida autonoma, consente alle auto di reagire in tempo reale alle situazioni in base ai dati raccolti dai sensori. Ebbene, secondo uno studio di Intel, un veicolo a guida autonoma connesso potrebbe generare la stessa quantità di dati di 3.000 utenti internet, mentre due auto in comunicazione tra loro arrivano a generare l’equivalente di 8-9.000 utenti internet. Tanto vale il futuro del Digital 5.0 fatto di prodotti e servizi superdigitalizzati avidi di chip, elaborazione dati e infrastrutture. Una montagna di dati da gestire alla velocità della luce. E una potenza informatica sempre più monstre necessaria per gestirli e farli fruttare. Ma c’è spazio per tutti sul mercato, dicono gli esperti, se è vero che il potenziale delle soluzioni di intelligenza artificiale può raggiungere 208 miliardi di dollari entro il 2030 secondo Pictet Asset Management. Quanto più il valore della mente umana potrà essere integrato nella tecnologia, dalla salute, all’automazione nel mercato del lavoro fino al mondo della formazione e dell’educazione, tanto più troveranno spazio in cui crescere sia giganti dei servizi cloud come Microsoft, Alphabet, Meta e Amazon definiti «hyperscaler», o i produttori “generalisti” di chip come il leader Nvidia, e i suoi fratelli minori, accanto ai produttori di chip altamente “specializzati” che lavorano per la stessa.

DAI SERVER ALLE MEMORIE

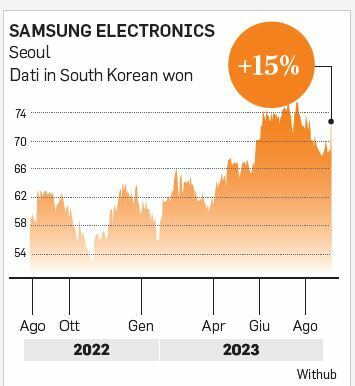

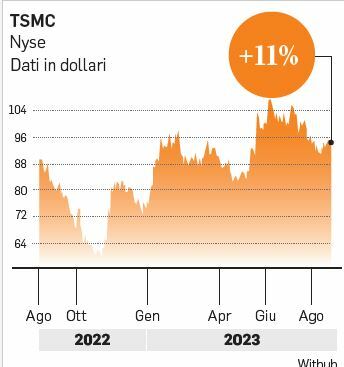

Del resto per far funzionare Chat-GPT di open AI servono circa 300.000 processori (280.000 CPU e 10.000 GPU) e Gartner prevede che il mercato globale dei semiconduttori per l’intelligenza artificiale crescerà al ritmo del 21% all’anno fino al 2027. Questi processori però non funzionano da soli: servono svariate tecnologie correlate, non solo per quest’applicazione, ma anche per i servizi e la tecnologia avanzata della Digital 5.0. Nord America e Cina rappresentano già il 70% del mercato dei processori. Ma anche se la Cina ha disponibilità limitata di chip avanzati e punta a un recupero accelerato, la crescita e la gamma in espansione di beni e servizi hanno implicazioni positive un po’ per tutte le società del settore tecnologico nel suo complesso, compresi semiconduttori, memorie (realizzate per i server), confezionamento di schede madri e montaggio. Le società asiatiche e dei mercati emergenti sono particolarmente esposte in questi ambiti ed ecco perché potranno avere un ruolo dominante, giurano da GAM. I chip di memoria avanzati, che immagazzinano ed elaborano dati, sono fondamentali per un’intelligenza artificiale che ha bisogno di capacità computazionale accelerata (con minor consumo di energia), e non solo della semplice capacità di immagazzinare dati. E allora, il settore delle memorie è un mercato con tre grandi operatori, e due delle tre società coreane (SK Hynix e Samsung Electronics) hanno una quota del 60%. I server di AI, da parte loro, stanno conquistando in fretta posizioni in Asia nella catena di distribuzione di prodotti ODM (Original Design Manufacturer), ovvero sviluppati dal fornitore, che grazie ad anni di sviluppo e interazione coi clienti hanno una quota di mercato del 90%. I progressi nei processori e nelle tecnologie correlate hanno spinto le fonderie verso il packaging avanzato, ma il mercato dei test e del confezionamento è ancora dominato dalle società asiatiche. E ancora, va ricordato che, per esempio, la taiwanese TSMC ha una quota del 60% nel mercato della fonderia per semiconduttori che, sommata alla quota di Samsung Electronics del 7% circa, fa salire la quota dell’Asia a oltre i due terzi. È proprio dai circuiti e dai semiconduttori prodotti dalle fonderie per i progetti di data center di società come Nvidia che nasce la fortuna dell’intelligenza artificiale.

© RIPRODUZIONE RISERVATA